KI und Energie: Wie viel Strom braucht künstliche Intelligenz?

KI soll helfen, Prozesse energieeffizienter zu machen und Ressourcen zu sparen. Auch sie selbst soll dereinst mit wesentlich weniger Energie arbeiten.

Alles zum Thema KI und Energie

- Wie viel Strom verbraucht ein Promot?

- Blick in die Zukunft: Stromverbrauch der Schweiz 2026

- Und der Stromverbrauch hierzulande?

- Neues Label für energieeffizientes Hosting

- Wasserbedarf von künstlicher Intelligenz

- Künstliche Intelligenz kann auch Energie und Ressourcen sparen

- Wo spart KI konkret Energie? Zwei Beispiele von ewz

- Wie wird künstliche Intelligenz selbst energieeffizienter?

- Wohin könnte gesparte Energie fliessen?

Wie viel Strom verbraucht ein Promot?

Wohl praktische jede*r sass schon einmal daheim vor dem PC und hat eine Frage oder einen Befehl – einen sogenannten Prompt – bei ChatGPT, Google Gemini oder Bing Chat eingegeben. Angesichts der zunehmenden Nutzung von KI ist jüngst die Frage nach dem nahezu exponentiell steigenden Energieverbrauch in den Fokus gerückt.

Doch selbst die Entwickler*innen und Betreiber*innen der KI wissen nicht exakt, wie viel Strom eine Anfrage bei ChatGPT oder Google Gemini verbraucht. Forschende versuchen durch Hochrechnungen ein klareres Bild zu gewinnen.

So sollen allein für das Training von ChatGPT-3 über mehrere Wochen fast 1’300 Megawattstunden (MWh) Strom verbraucht worden sein, so viel wie rund 420 Schweizer Vier-Personen-Haushalte in einem Jahr verbrauchen. Dieser hohe Stromverbrauch hat gemäss Report der Stanford Universität gleichzeitig 502 Tonnen Treibhausgas-Emissionen verursacht.

Das wesentlich komplexere Modell ChatGPT-4 soll gar 62’320 MWh Energie für das Training benötigt haben. Natürlich verbraucht ChatGPT aber auch nach dem Training bei seiner Nutzung enorm viel Strom.

Doch wie viel Energie denn nun ein einzelner Prompt benötigt, lässt sich nicht so einfach beantworten. Denn der Energieverbrauch schwank enorm. Aktuelle Sprachmodelle unterscheiden sich stark in ihrer Effizienz. Auch die Komplexität des Prompts spielt eine wichtige Rolle.

Aktuelle Schätzungen gehen von 0,3 Wattstunden (Wh) für einen einfachen Prompt aus. Das entspricht in etwa dem Verbrauch einer Suchanfrage bei Google, Bing oder Ecosia. Komplexere Prompts brauchen entsprechend mehr Energie. Ein 5-Sekunden-Video, das mit KI generiert wurde, braucht gegen eine Kilowattstunde Strom, wie die Autoren des MIT Technology Review aufzeigen.

Ein durchschnittlicher Prompt bei ChatGPT 4 oder Perplexity benötigen zwar mehr Energie als eine simple Google-Suche, trotzdem würden solche einfachen Verwendungen von Chatbots nur einen kleinen einstelligen Prozentanteil des gesamten Ressourcenverbrauchs von KI ausmachen, wie es auf dem Social Media Watchblog SMWB heisst. Und: «Es gibt Dutzende Verhaltensänderungen, die mehr bewirken, als weniger generative KI zu nutzen», schreiben die Autoren.

.

«Aktuelle Schätzungen gehen von 0,3 Wattstunden (Wh) für einen einfachen Prompt aus. Das entspricht in etwa dem Verbrauch einer Suchanfrage bei Google, Bing oder Ecosia.»

Der Blick in die Zukunft: Plus zehnmal die Schweiz bis 2026

Eine der ersten Prognosen zum künftigen Stromverbrauch liefert die Internationale Energieagentur (IEA) in ihrem aktuelle Bericht vom Januar 2024. Die Zahlen beeindrucken. So könnte der Stromverbrauch der weltweiten Rechenzentren inklusive KI-Anwendungen und Kryptowährungen von 460 Terawattstunden (TWh) im Jahr 2022 auf 620 bis 1’050 TWh im Jahr 2026 steigen.

Je nach Entwicklung wird also zusätzlich Strom benötigt, der mindestens dem Jahresverbrauchs von Schweden bis maximal jenem von Deutschland entspricht – oder anders: rund zehnmal jenem der Schweiz mit rund 57 TWh pro Jahr. Dies hängt nicht zuletzt vom technologischen Fortschritt ab, der Effizienzsteigerung und davon, wie rasch KI in den verschiedensten Sektoren implementiert wird.

Hörtipp: Podcast von OMR Education, 00:10:30

«Alle grossen Tech-CEO rechnen als Hauptproblem damit, die Energie zu beschaffen.»

Und der Stromverbrauch hierzulande?

In Europa weist die Schweiz die zweithöchste Dichte an Rechenzentren pro Kopf aus. Insgesamt 93 Stück waren es bei der Erhebung des Immobiliendienstleisters CBRE von 2020. Aufgrund der regen Bautätigkeit dürften es inzwischen rund 100 Rechenzentren sein. Und die brauchen Strom. [Siehe auch: Artikel über ein Schweizer Datacenter – eine richtiggehende Sicherheitsburg]

Laut Bundesamt für Energie (BFE) betrug der Stromverbrauch durch Rechenzentren 2019 2,1 TWh, was 3,6 Prozent des gesamten Schweizer Stromverbrauchs entsprach. Und er steigt kontinuierlich, wie eine weitere Analyse im Auftrag des BFE zeigt.

Bis 2025/2026 dürften Rechenzentren rund 6 Prozent des Schweizer Stroms beanspruchen. Und KI-Anwendungen wurden in diesen Szenarien noch gar nicht berücksichtigt! Denn 2021, als die Analyse publiziert wurde, rechnete noch niemand mit der rasanten Entwicklung von KI.

KI treibt Stromverbrauch der hiesigen Rechenzentren in die Höhe

Professor Adrian Altenburger, Instituts- und Studiengangleiter für Gebäudetechnik und Energie an der Hochschule Luzern (HSLU) und Co-Autor der Analyse schätzt, dass bis 2030 der Stromverbrauch in den Rechenzentren infolge der neuen KI-Anwendungen bereits 8 TWh ausmachen könnte, das wären 14 bis 15 Prozent des gesamten Schweizer Stromverbrauchs.

Altenburger hat vor seiner Forschungs- und Lehrtätigkeit selbst Rechenzentren geplant und gebaut. «Die Frage ist, ob wir den Rechenzentren die zusätzliche Menge Strom dann auch mit der nötigen Infrastruktur zur Verfügung stellen können», gibt Altenburger zu bedenken.

Neues Label für energieeffizientes Hosting

Rechenzentren und Hosting könnten energieeffizienter werden. Um diese Entwicklung zu beschleunigen hat die Swiss Data Centre Efficiency Association (SDEA), eine Vereinigung von Unternehmen und akademischen Institutionen, bereits 2020 ein neues Label vorgestellt. Seit Sommer 2024 können sich alle Unternehmen, die Rechenzentren betreiben oder Platz für ihre Server mieten, registrieren und den Energieeffizienzrechner der SDEA nutzen. Anschliessend besteht die Möglichkeit, sich mit dem SDEA Label zertifizieren zu lassen.

Künstliche Intelligenz ist durstig.

Nicht nur der Energiebedarf der KI ist immens, sondern auch der Wasserverbrauch, um die IT-Infrastruktur zu kühlen, schlägt massiv zu Buche, wie ein Team von US-Forschenden in einer Analyse zeigen konnte.

So verbrauchen 20 bis 50 Prompts bei ChatGPT 3 einen halben Liter Wasser. Das klingt erstmal nach wenig, doch bei den Milliarden von Prompts, welche User*innen weltweit eintippen, ergibt sich ein enormer Wasserverbrauch.

Problematisch ist dies, wenn Rechenzentren mittels Verdunstung gekühlt werden und das Frischwasser für andere Nutzungen nicht mehr zur Verfügung steht. Dagegen geht das Wasser in Rechenzentren mit geschlossenem Kreislauf nicht verloren.

Künstliche Intelligenz kann Energie und Ressourcen sparen

Während für viele User*innen ChatGPT und Co. nette Spielereien sind, nutzen Unternehmen KI, um Prozesse effizienter zu machen und Ressourcen zu sparen oder ganze Städte in Smart Cities zu transformieren und beispielsweise intelligente Verkehrsleitsysteme aufzubauen. Solche Optimierungen können auch den Effekt haben, enorm viel Energie einzusparen.

Adrian Altenburger

Genaue Prognosen und gezielte Wartungen bei ewz

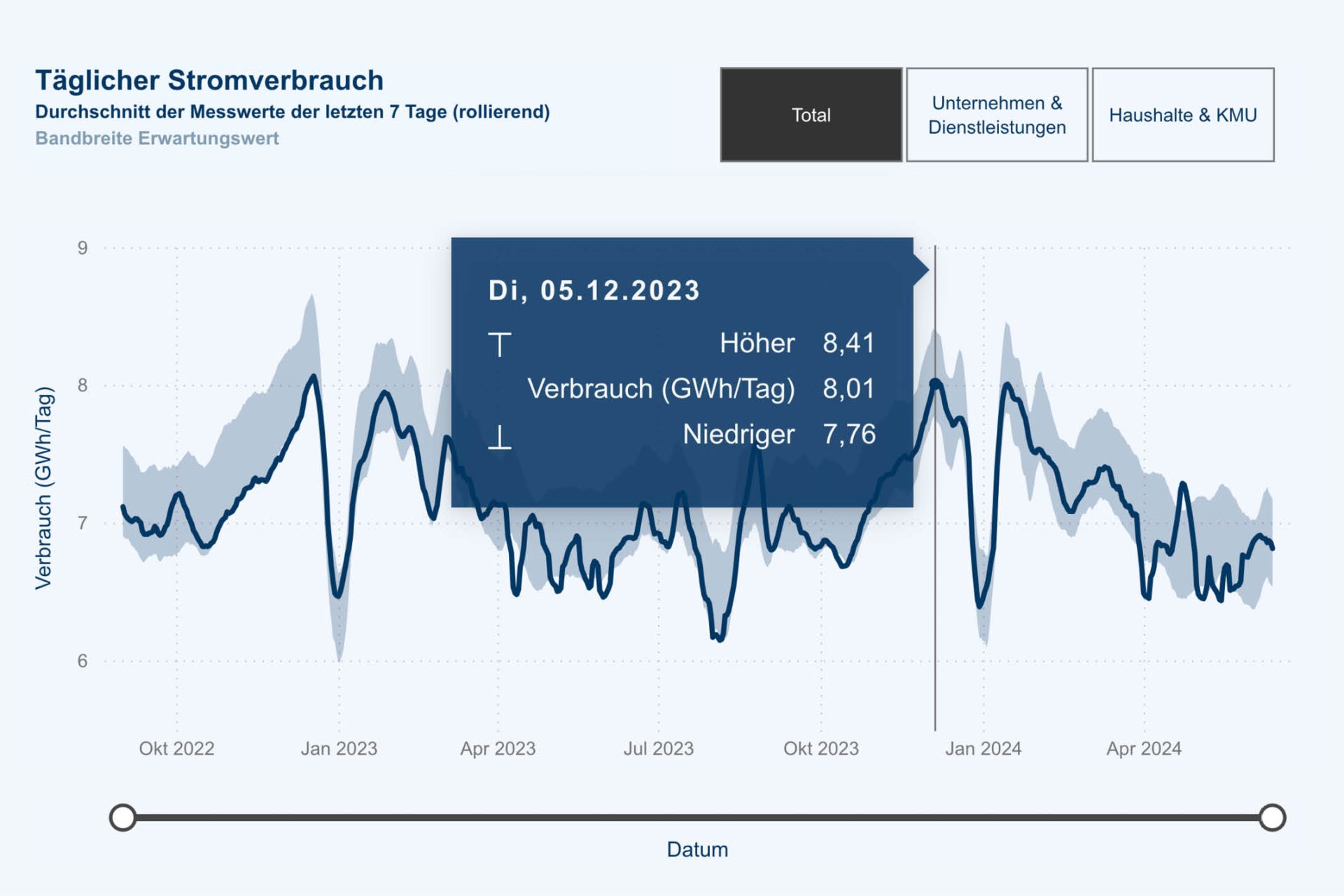

Auch bei ewz analysiert man das Potenzial von KI. Beispielsweise sind Prognosen zur Stromproduktion und zum Bruttoenergieverbrauch in der Stadt Zürich mithilfe von KI genauer geworden. Denn mit dem Zubau an erneuerbaren Energien sind genaue Daten essenziell, um das Stromnetz stabil zu halten.

Je genauer ewz den Stromverbrauch kennt – was durch rückblickendes sowie vorausschauendes Analysieren möglich ist – desto besser können die dortigen Teams Energiespartipps geben oder auch den Netzausbau (Stichwort Smart Grids) planen und umsetzen.

Des Weiteren ist KI bei der Instandhaltung von Maschinen interessant, um beispielsweise Wartungsarbeiten weiter zu optimieren, womit sich Energie einsparen liesse:

Doch wie steht es eigentlich um die KI selbst? Lässt sich der enorme Energieverschleiss reduzieren?

powernewz in Ihrer Mailbox

Wie wird künstliche Intelligenz selbst energieeffizienter?

Damit KI für dieselbe oder für mehr Leistung weniger Energie benötigt, müssen Hard- und Software effizienter arbeiten. Daran wird weltweit intensiv geforscht.

Für Bereiche, in denen die Resultate nicht ganz so genau sein müssen, erforscht man, wie die entsprechenden Rechenprozesse weniger genau ausgeführt werden können, was weniger Energie benötigt.

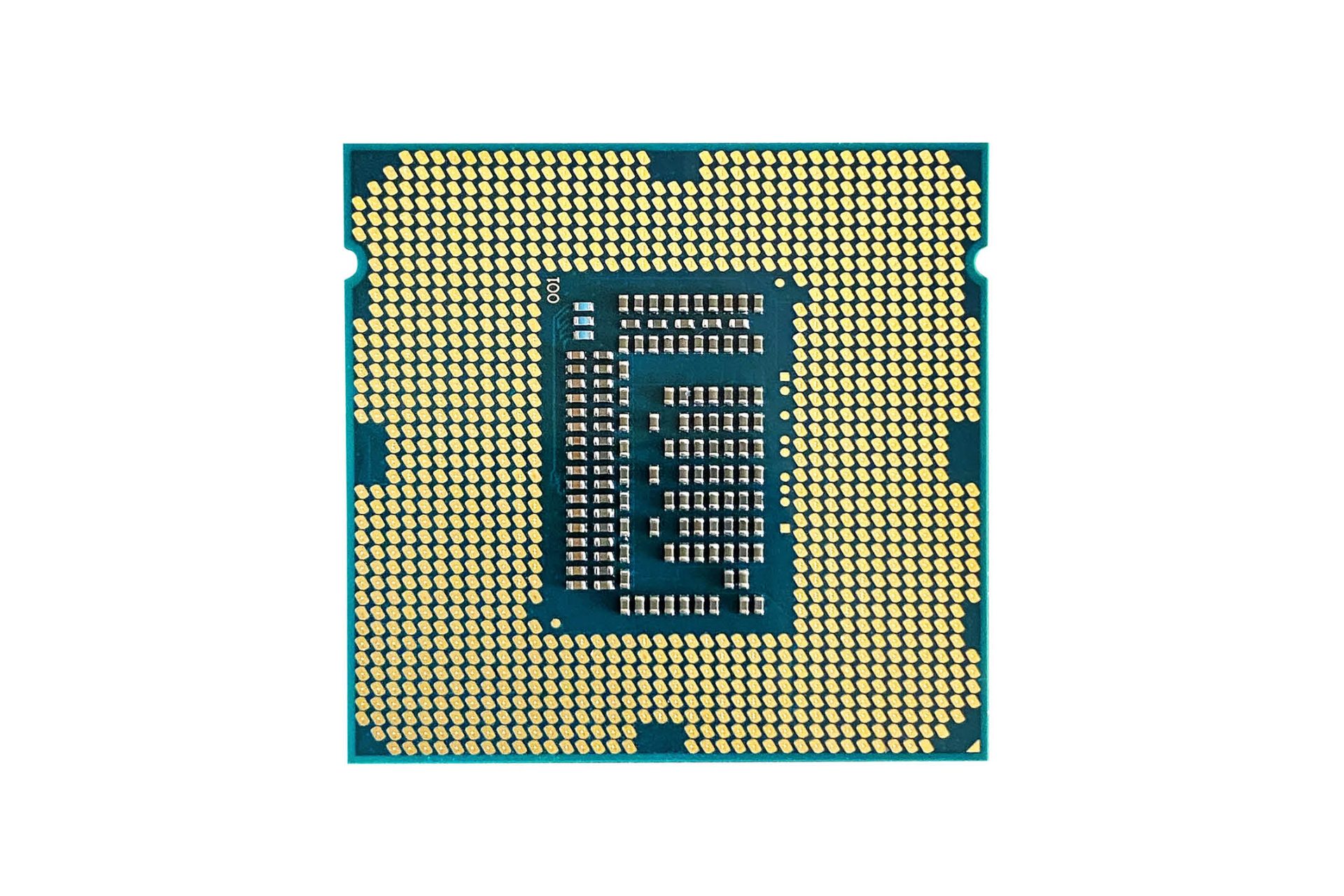

Vielversprechend ist die Entwicklung neuartiger Chips. Das Team um Professor Christian Mayr an der Technischen Universität Dresden hat beispielsweise einen neuartigen Chip entwickelt und 50’000 Stück im Supercomputer Spinnaker 2 verbaut. Dieser wird in Dresden bereits zu Forschungszwecken genutzt. Anders als in gängigen Chips werden die Zellen in diesen sogenannten neuromorphen Chips nur aktiv, wenn sie ein Signal erhalten. Die Arbeitsweise spare verglichen mit heutigen Supercomputern 90 Prozent Energie, erklärt Mayr gegenüber der NZZ.

Am gleichen Ort speichern und verarbeiten spart viel Energie

Auch das Hin- und Herschieben der Daten zwischen Speicher und Prozessor, wo sie verarbeitet werden, frisst viel Strom. Anders unser Gehirn: Hier werden Daten am gleichen Ort gespeichert und verarbeitet. Diesen hocheffizienten Vorgang sollen sogenannte Memristoren (von Memory/Speicher und Resistor/Widerstand) in den Chips imitieren.

«Memristive Zellen ermöglichen es, diese gigantischen Datensätze direkt im Speicher zu verarbeiten, ohne sie zwischen Prozessor und Speicher hin und her zu transportieren», erklären die Forschenden des Forschungszentrums Jülich.

Gesparte Energie dürfte direkt in neue KI-Anwendungen fliessen

Bis diese Technologien skalierbar sind und für KI-Anwendungen tatsächlich relevante Effizienzfortschritte erzielen, wird es noch einige Jahre dauern. Und so vielversprechend die Entwicklungen im Bereich Energieeffizienz auch klingen: Ein grosser Teil der eingesparten Energie dürfte dem Rebound-Effekt zum Opfer fallen, indem die freiwerdende Energie direkt in neue KI-Anwendungen fliessen